文章來源: 矽星人Pro

文章作者: 張潇雪

最近在許多美國開發者的口中,一個開源模型經常被提及,它的發音聽起來是“困”。乍一聽到總讓人一頭霧水。哪個開發者天天用中文說困啊。

其實,這就是阿裡的開源模型通義千問,這個取自拼音縮寫的名字Qwen,被老外自成一體給了一個新發音。

除了Qwen,還有好幾個國産開源大模型在海外激戰正酣,并且頻繁刷新各項benchmarks,呼聲和反響甚至比在國内還高。這些來自中國團隊的開源模型們不僅不“困”還進展飛速。

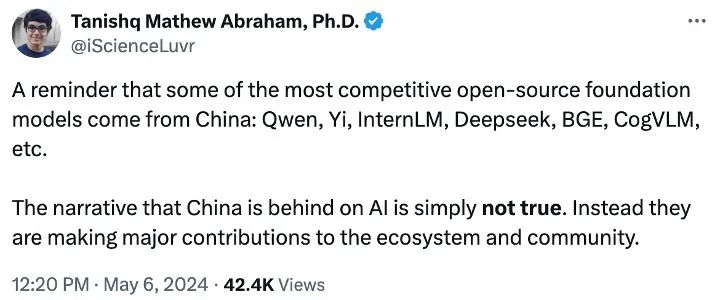

Stability AI研究主管Tanishq Mathew Abraham幹脆發文提醒道:“許多最具競争力的開源大模型,包括Owen、Yi、InternLM、Deepseek、BGE、CogVLM 等正是來自中國。關于中國在人工智能領域落後的說法完全不屬實。相反,他們正在為生态系統和社區做出重大貢獻。”

那到底現如今,中國的開源大模型們厲害到什麼程度?下面逐一來看。

01

通義千問:登頂主流開源榜,八種尺寸個個能打

5月9日,阿裡雲正式發布地表最強中文開源大模型通義千問2.5。相較上一版本,2.5版模型的理解能力、邏輯推理、指令遵循、代碼能力分别提升9%、16%、19%、10%,中文語境下性能“全面趕超 GPT-4”。

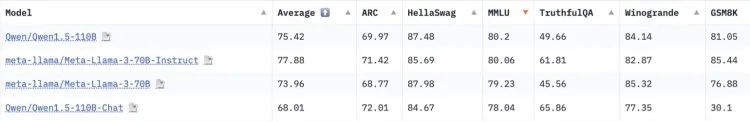

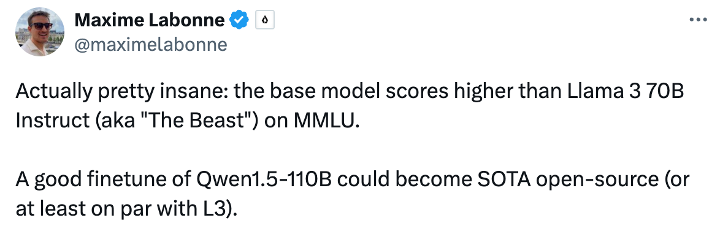

上月底,團隊剛開源了Qwen1.5系列首個千億參數級别模型Qwen1.5-110B,能處理 32K tokens 上下文長度,支持英、中、法、西、德等多種語言。技術上采用Transformer架構,并具有高效的分組查詢注意力機制。基礎能力可逼近Meta-Llama3-70B和Mixtral-8x22B,在MT-Bench和AlpacaEval 2.0的聊天場景評估中也表現出色。

Liquid AI高級機器學習科學家Maxime Labonne看了表示:“太瘋狂了。Qwen1.5-110B在 MMLU 上的得分竟然高于‘性能野獸’ Llama 3 70B的instruct版本。微調後它将有可能成為最強開源SOTA模型,至少能和Llama 3媲美。”

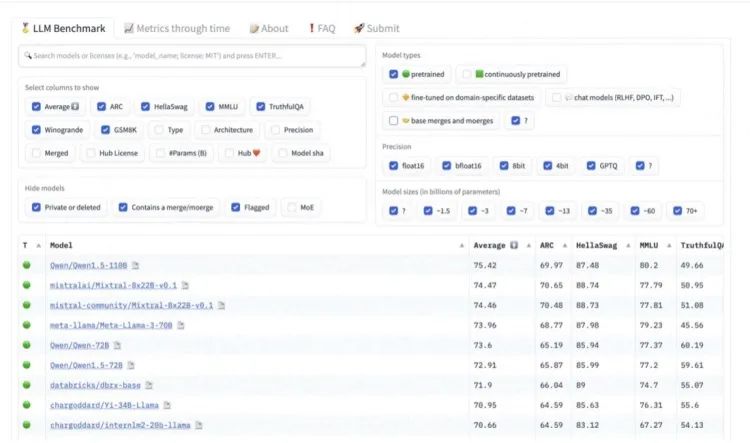

Qwen1.5-110B還曾憑實力登頂Hugging Face 開源大模型榜首。

實際上,自從通義千問去年8月宣布“全模态、全尺寸”開源路線以來,就開始馬不停蹄地疊代狂飙,強勢闖入海外AI開發者社區的視野。

為滿足不同場景需求,通義一共推出橫跨5億到1100億參數規模的八款大模型,小尺寸如0.5B、1.8B、4B、7B、14B可以在端側設備便捷部署;大尺寸如72B、110B能支持企業和科研級應用;而32B的中等尺寸則力求在性能、效率和内存之間找到最佳性價比。

在各種尺寸的靈活選擇下,通義千問其它參數的模型性能也好評如潮。

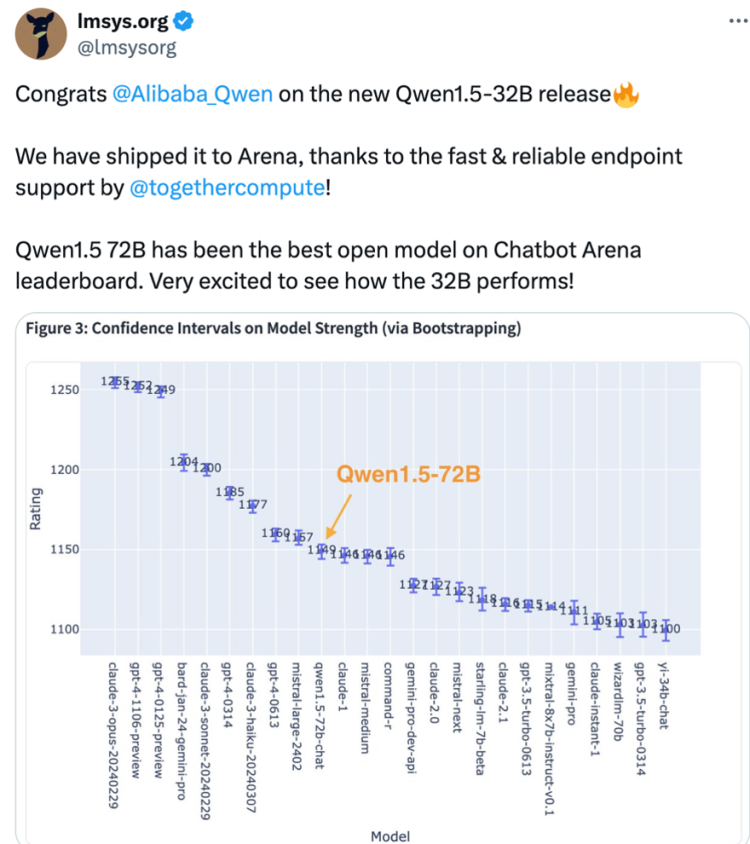

其中Qwen-1.5 72B曾在業界兵家必争之地:LMSYS Org推出的基準測試平台Chatbot Arena上奪冠,Qwen-72B也多次進入“盲測”對戰排行榜全球前十。

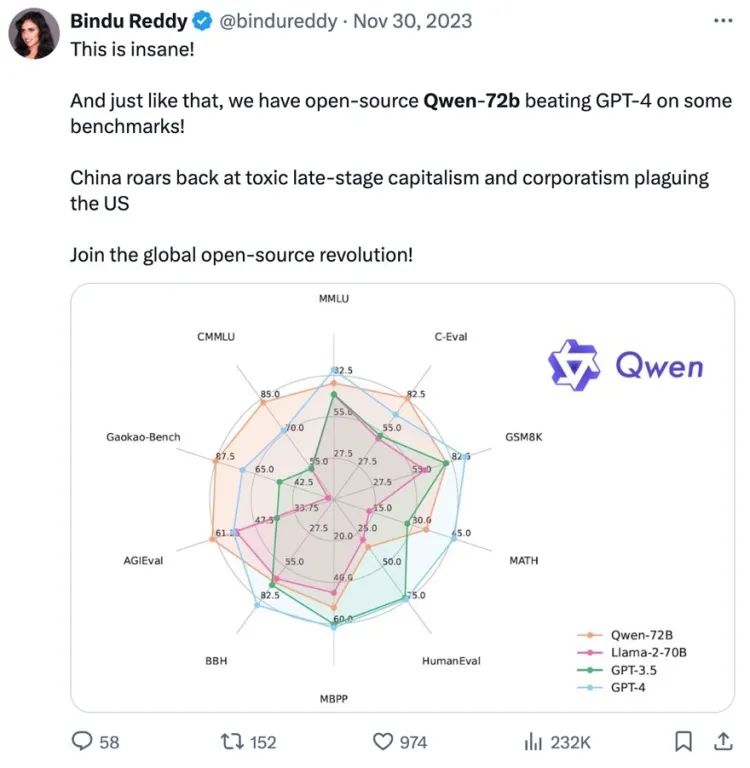

推特大V 、Abacus.AI公司創始人和首席執行官Bindu Reddy直接挂出Qwen-72B的基準測試成績興奮地說:“開源的 Qwen-72B 在一些benchmarks上擊敗了 GPT-4!中國正在回擊困擾美國的AI公司壟斷!加入全球開源革命吧!”

另有網友指出Qwen-72B基礎模型在VMLU ,也就是越南語版本的MMLU上無需微調、開箱即用,即可達到與 GPT-4 相同分數的最先進水平。

較小參數的Qwen家族成員更是備受歡迎。

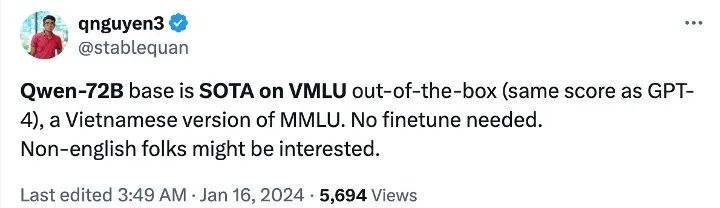

在Hugging Face平台上,Qwen1.5-0.5B-Chat和CodeQwen1.5-7B-Chat- GGUF上月分别獲得22.6萬次和20萬次下載量。包括Qwen1.5-1.8B和Qwen1.5-32B在内的5個模型上月下載量都在10萬次以上。(總共發布76個模型版本,也真的堪稱行業勞模。)

我們還注意到,在今天很多的對模型性能進行分析的論文中,Qwen也幾乎成為必選的分析标的,成為開發者和研究者默認的最有代表性的模型之一。

02

DeepSeek V2:大模型屆的“拼多多”

5月6日,私募巨頭幻方量化旗下的AI公司深度求索發布全新第二代MoE大模型DeepSeek-V2,模型論文雙開源。

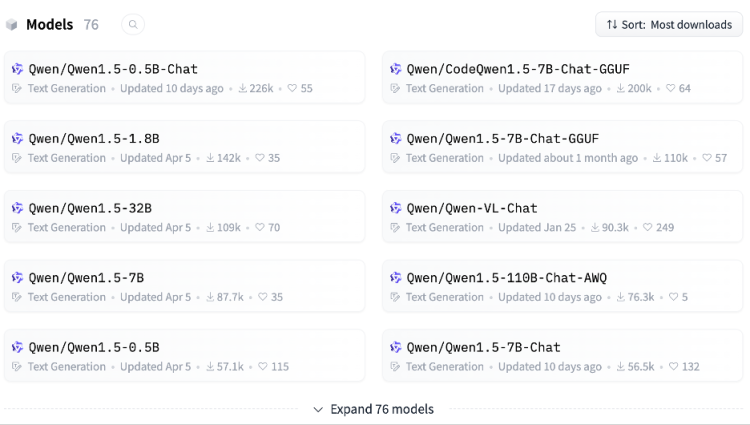

其性能在AlignBench排行榜中位列前三,超過GPT-4且接近GPT-4-Turbo。MT-Bench中屬于頂尖級别,與LLaMA3-70B比肩,遠勝Mixtral 8x22B。支持 128K 的上下文窗口,專精于數學、代碼和推理任務。

除了采用MoE架構,DeepSeek V2還創新了Multi-Head Latent Attention機制。在總共 236B 參數中,僅激活21B 用于計算。計算資源消耗僅為Llama 3 70B 的五分之一,GPT-4 的二十之一。

除了高效推理,最炸裂的是,它實在太物美價廉了。

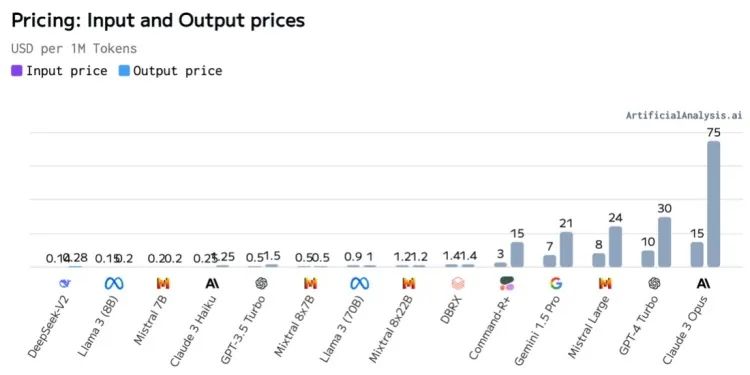

DeepSeek V2在能力直逼第一梯隊閉源模型的前提下, API定價降到每百萬tokens輸入1元、輸出2元(32K上下文),僅為Llama3 70B七分之一,GPT-4 Turbo的近百分之一,完全就是價格屠夫。

便宜歸便宜,DeepSeek卻并不賠錢。它在 8 x H800 GPU 的機器上可以實現每秒5萬tokens峰值吞吐。按輸出API 價格計算,相當于每個節點每小時收入50.4 美元。國内 8xH800 節點的成本約 15 美元/小時,因此假設利用率完美,DeepSeek 每台服務器每小時的利潤高達 35.4 美元,毛利率可達 70% 以上。

另外DeepSeek平台還提供與OpenAI兼容的 API,注冊就送500萬tokens。

——高效、好用、擊穿地闆的價位,不正是開源社區迫切需要的嗎?

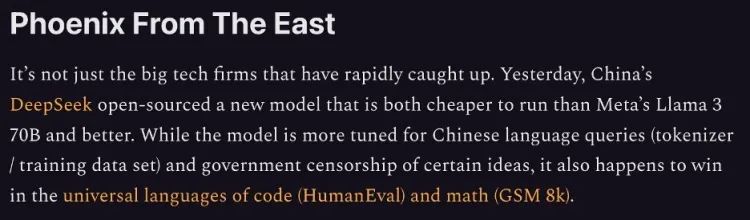

這直接引起權威半導體研究和咨詢公司SemiAnalysis高度關注,5月7日發長文點名DeepSeek V2是“東方崛起的神秘力量”,憑超高性價比對其它模型實現“經濟學碾壓”,指出“OpenAI和微軟的行業挑戰可能不隻來自美國。”

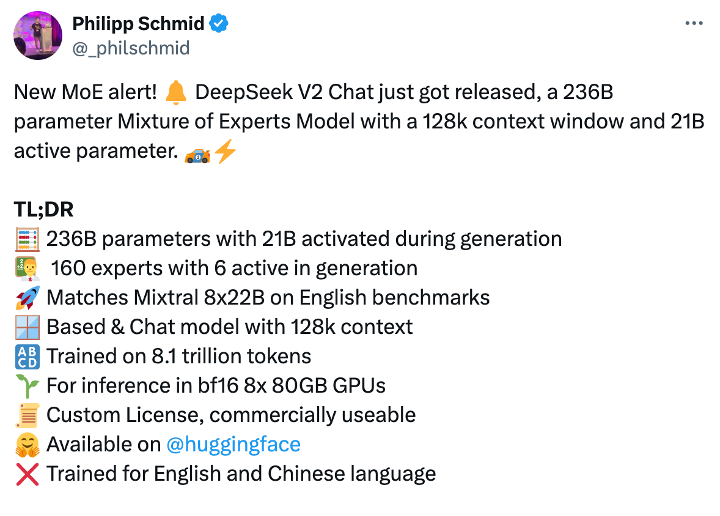

Hugging Face技術主管Philipp Schmid在X發文,列出DeepSeek V2各項技能點向社區隆重推薦。上線僅四天,Hugging Face上的下載量已達3522次,在GitHub也瞬間收獲1200顆星星。

03

面壁智能:另辟蹊徑、以小博大

在通往 AGI 的路上,有的像DeepSeek這樣面對算力為王,主攻經濟高效;也有像通義千問那樣全面開花,布局各種模型規模;但絕大多數公司的路線是遵循Scaling Law,狂卷大參數。

而面壁智能卻在走一條相反的路線:盡可能把參數做小。以更低的部署門檻、更低的使用成本讓模型效率最大化,“以小博大”。

今年2 月 1 日,面壁智能推出隻有24億參數量的 MiniCPM-2B模型,不僅整體領先于同級别Google Gemma 2B,還超越了性能标杆之作 Mistral-7B,且部分勝過大參數的Llama2-13B、Llama2-70B-Chat等。

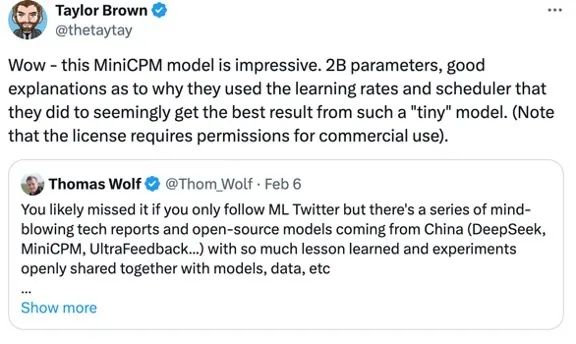

在海外社區開源後,Hugging Face聯合創始人Thomas Wolf緊接着發文說,“中國出現了一系列令人驚歎的技術報告和開源模型,比如 DeepSeek、MiniCPM、UltraFeedback...它們的數據和實驗結果都被公開分享,這種對知識的坦誠分享在最近的西方科技模型發布中已經丢失了。”

網友轉發贊同:“MiniCPM 實在令人印象深刻,擁有 20 億參數,并從這麼微小的模型中獲得了最佳結果。”

另一位同讀過MiniCPM模型論文的網友更是激動盛贊,“面壁智能正掀起一場改變遊戲規則的革命。”

“想象一下,在你口袋裡擁有強大的人工智能,而不僅僅是雲端。MiniCPM-2B 不是普通的模型。它隻擁有 24 億參數,卻超越了自己 5 倍大的巨人!尺寸并不是唯一标準,關鍵在于如何利用它。這就是邊緣人工智能未來的願景,可能重新定義我們與技術的互動。”

70天後,面壁智能乘勝追擊,繼續發布了新一代“能跑在手機上的最強端側多模态大模型”MiniCPM-V 2.0,參數規模 2.8B。

據其在Hugging Face上介紹,MiniCPM-V 2.0 在包括 OCRBench、TextVQA、MME在内的多個基準測試中都達到了開源社區最佳水平。在覆蓋 11 個流行基準測試的OpenCompass 綜合評估上,它的性能超過Qwen-VL-Chat 9.6B、CogVLM-Chat 17.4B 和 Yi-VL 34B。甚至在場景文字理解方面已接近 Gemini Pro 的性能。

04

“與Mistral們相比,中國的許多模型是真的在開源”

除了以上提到的DeepSeek、Qwen和MiniCPM,上海人工智能實驗室和商湯聯合研發的InternLM、零一萬物的Yi系列、智譜AI的多模态大模型CogVLM等等中國的開源模型也在開發者社區裡備受歡迎。

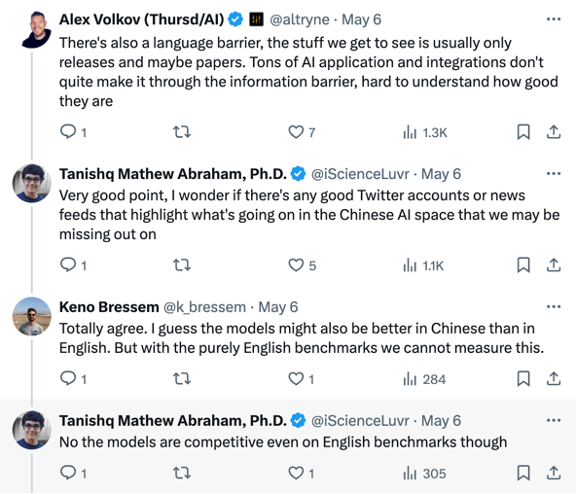

人們在推特還特别讨論到,由于中英文間的語言障礙,海外通常能看到中國大模型也隻是發布的一部分,太多AI應用和集成沒有被完全展現。推測這些模型在中文上表現應該比英文更好。但即便如此,它們在英文基準測試上已具備相當的有競争力。

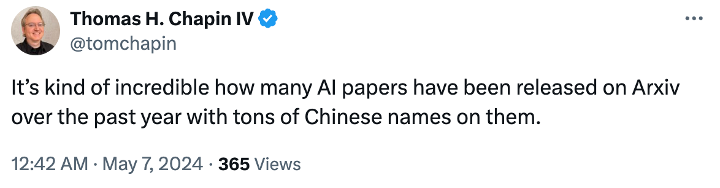

還有人提出,自己屬實被過去一年中Arxiv上AI論文裡中文署名作者的龐大數量震驚到了。

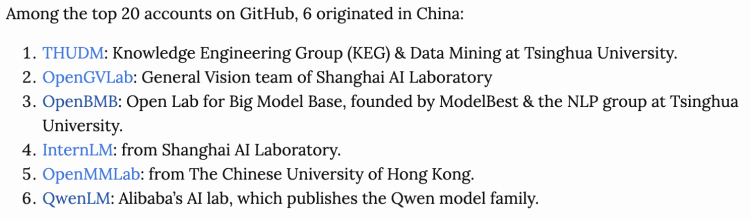

前斯坦福兼職講師、Claypot AI聯合創始人Chip Huyen在調研過900個流行開源AI工具後,在個人博客中分享自己的發現:“在GitHub排名前20的賬戶中,有6個源自中國。

開源的一個好處就是讓陰謀論無法繼續。

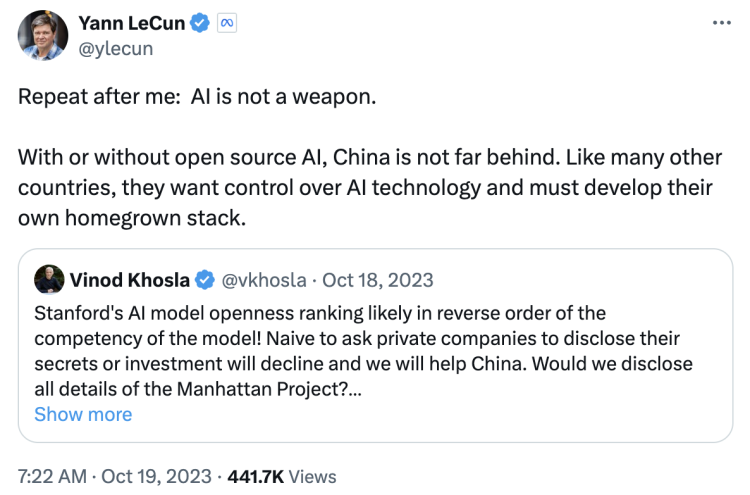

OpenAI早期投資人Vinod Khosla曾在X發文稱,美國的開源模型都會被中國抄去。

但這番言論馬上被Meta的AI教父Yann LeCun反駁:“AI不是武器。無論我們是否把技術開源,中國都不會落後。他們會掌控自己的人工智能,開發自己的本土技術堆棧。”

而且,在開源的誠意上,中國模型也開始被開發者認可。有在斯坦福讀書的同學也分享到,教授在課堂上大力稱贊中國開源模型,特别是開誠布公地與社區積極分享成果,跟歐美一些頭頂“開源”名号的明星公司不同。有網友也表達了和這個教授相似的觀點,“美國最該尴尬的,是今天中國開源模型們重大的貢獻”。

大模型技術的發展中開源注定将繼續扮演重要的推動角色,而且這也是首次有開源和閉源技術幾乎齊頭并進的景象出現。在這股浪潮裡,中國的開源貢獻者正在通過一個個更有誠意的開源産品給全球社區做着貢獻。