文章來源:矽星GenAI

作者:張潇雪

曾通過Gemini 1.5 Pro指出Sora生成視頻不合理,質疑它擔不起“世界模型”稱号的Google,G字輩模型喜添新成員。

今天,Google DeepMind推出人工智能模型「Genie」,一個能夠生成交互式視頻遊戲的 AI。它可以根據用戶提示,将合成圖像、真實照片、手繪草圖或想法轉換成無盡多樣的,可互動、可控制動作的虛拟世界。

Google認為,現在市面上許多優秀模型都能帶來新穎豐富的内容。但如果給定一個來自互聯網的大量視頻語料庫,不僅能訓練模型生成圖像或視頻,還可以創造完整的互動體驗呢?

團隊将其概括為一種全新GenAI範式:「生成式交互環境」,并稱由于Genie實現了人們與想象世界的自由互動,本質上它才是真正的“基礎世界模型”。

一鍵生成無限可玩世界

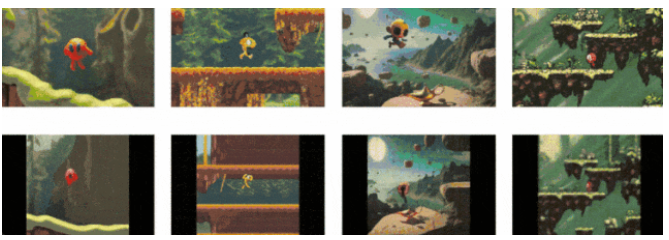

在成果演示中,研究人員将Imagen2生成的圖像作為起始幀,通過Genie賦予生命:

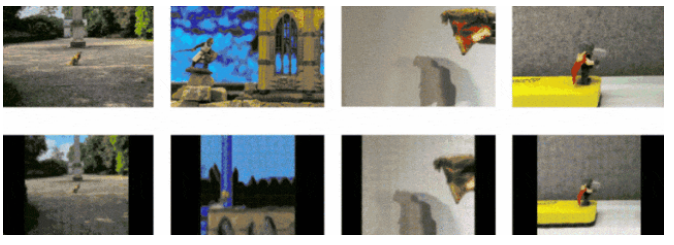

不僅如此,真實世界中的物體也可以自由操控:

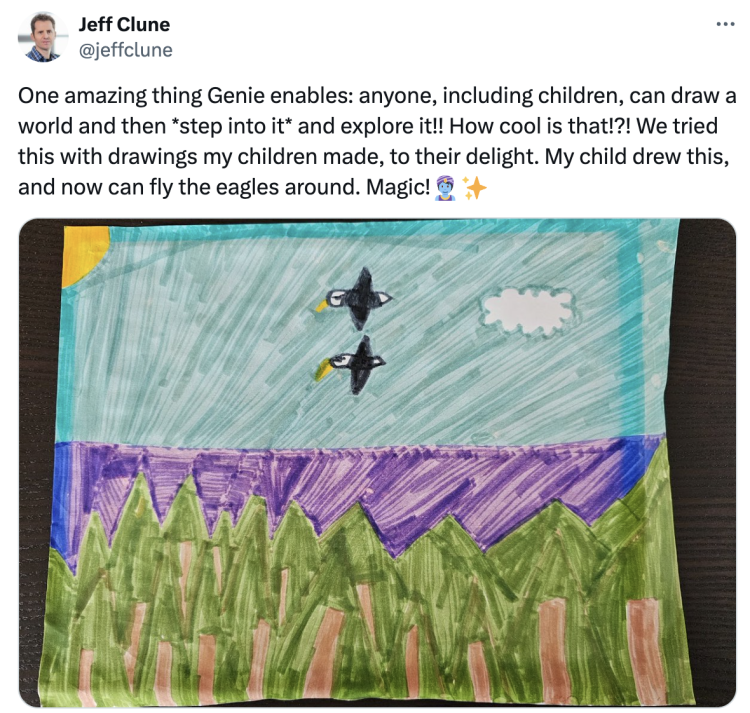

甚至小朋友充滿童真的草圖,也變成了想象力無限的遊戲:

Genie為生成和步入虛拟世界開啟了更多新的方式,也能夠啟迪更廣泛的内容創作者。DeepMind高級研究顧問Jeff Clune在X興奮地分享道:

“這裡實現的一個驚人之處是,任何人包括孩子們都可以繪制一個世界,然後進入其中探索它。這有多酷啊?我們用我孩子的畫作測試了Genie。他們畫了兩隻鷹,然後就可以操控着鷹到處飛。簡直魔法!”

20萬小時視頻訓練,無需行動标簽即可學習控制

在《一千零一夜》裡,僅需摩擦神燈,精靈就會出來為人們實現願望。而喚醒AI世界裡的Genie,首先必須把知識和能力填充進燈裡。

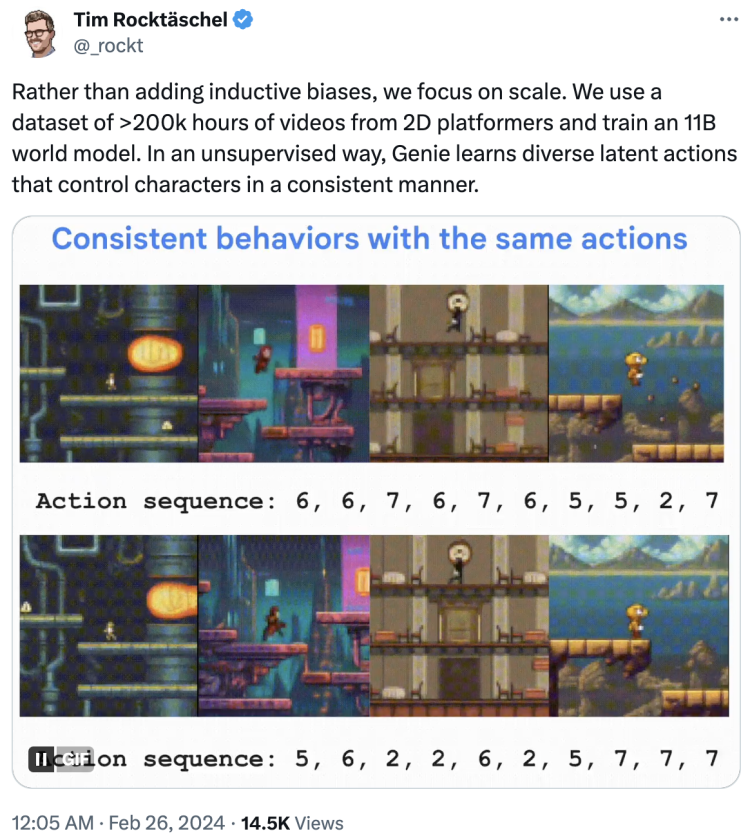

項目負責人Tim Rocktäschel在X上寫道,與“inductive biases(歸納偏見)”不同,團隊專注于規模,使用了一個包含超過20萬小時的2D平台遊戲視頻數據集,來訓練這個 110 億參數的世界模型。

作為首個從未标記的互聯網視頻中以無監督方式訓練的生成式交互環境, Genie學會了控制角色的各種潛在動作,并且保持一緻性。

實現這種精細控制是一個挑戰,也正是Genie的獨特之處。因為互聯網視頻通常沒有關于哪個動作正在執行,甚至哪個圖像部分應該被控制的标簽。但Genie卻可以确定誰是主角,并使用戶能夠在生成的世界中逐幀控制該角色。

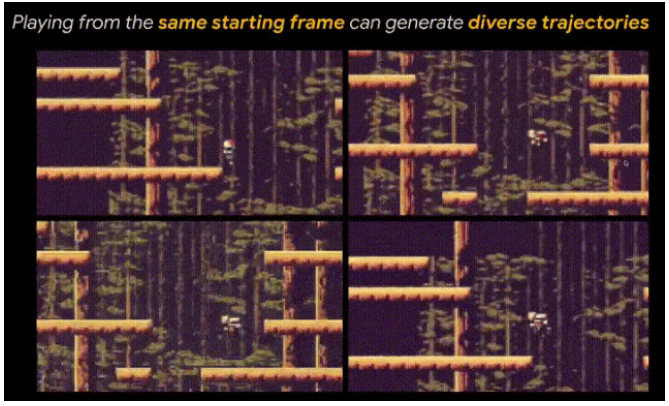

并且,Genie通過學習産生的這個既豐富多樣又一緻性強的潛在動作空間,對于人類來說是可解釋的。換句話說,即使是未經訓練的用戶,在與 Genie 生成的遊戲世界互動幾次之後,也能自然理解并做出向左、向右或跳躍等常見動作,形成多樣化的運動軌迹。

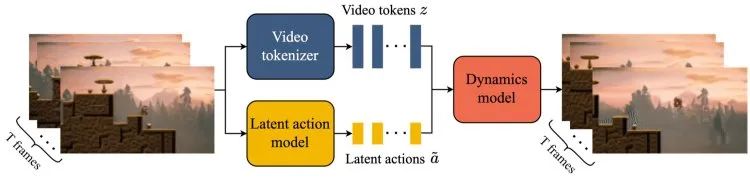

項目組也解釋了Genie模型背後的三個關鍵組件:

• 一個潛在動作模型(LAM),用于推斷每對幀之間的潛在動作。

• 一個視頻分詞器(Video tokenizer),具有時間感知能力,與OpenAI在Sora中的“patches”概念類似,能将原始視頻壓縮為離散令牌。

• 一個動力學模型(Dynamics model),能夠在給定潛在動作和過去幀令牌的條件下,預測視頻下一幀。

整個運行過程如上圖所示:将幀視頻作為輸入,通過視頻分詞器将它們轉換成離散的令牌z,并由潛在動作模型在每幀之間推斷潛在動作a。之後這兩者都傳遞給動力學模型,以疊代方式生成下一幀的預測。

論文地址在這裡,感興趣的小夥伴可以自行查看:https://arxiv.org/abs/2402.15391

關于“世界模型”的較勁

在整個Genie的介紹中,“動作”成了出現頻率最高的詞彙。這也正是Google對于「世界模型」的理解。

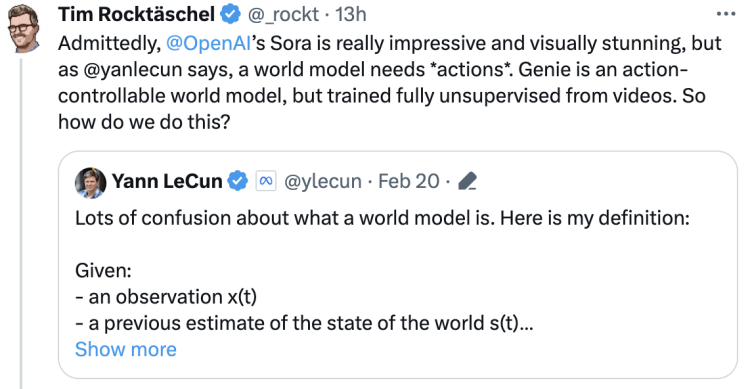

這個近期被OpenAI的Sora點燃的課題曾引發一場業界大辯論。Meta首席科學家Yann LeCun就首當其沖質疑了Sora的技術路徑。他認為,僅從語言提示生成看起來逼真的視頻,并不意味着系統真正理解了物理世界,“内容生成”實則與世界模型中進行的因果預測非常不同。

Tim Rocktäschel此處轉發表示贊同,先是肯定Sora 在視覺效果上确實令人印象深刻。接着表示“正如 LeCun所說,一個世界模型需要動作”,Genie 才是那個可以控制動作的世界模型。

曾表揚Sora是一個「數據驅動的物理引擎」,一個「可學習的模拟器或世界模型」的英偉達高級研究科學家Jim Fan,也再次開啟誇誇模式:

“Tim 是我所知道的最有想象力的研究者之一,而 Genie 是他最具想象力的作品。不同于Sora,Genie 實際上是一個以推斷合适動作為驅動的世界模型。

2024年也将是基礎世界模型的一年!”

怎麼條條大路通AGI?

Google還進一步表示,“Genie有朝一日會成為訓練多任務智能體的基礎世界模型,是生成式虛拟世界的未來”。

以往許多成果已經表明,遊戲環境可以作為開發AI Agent的有效試驗場。雖然目前的Genie隻是基于遊戲數據訓練的,但它是一種通用方法。不僅限于二維環境或應用程序,還适用于多種類型的數據和場景,而無需任何額外專業知識。

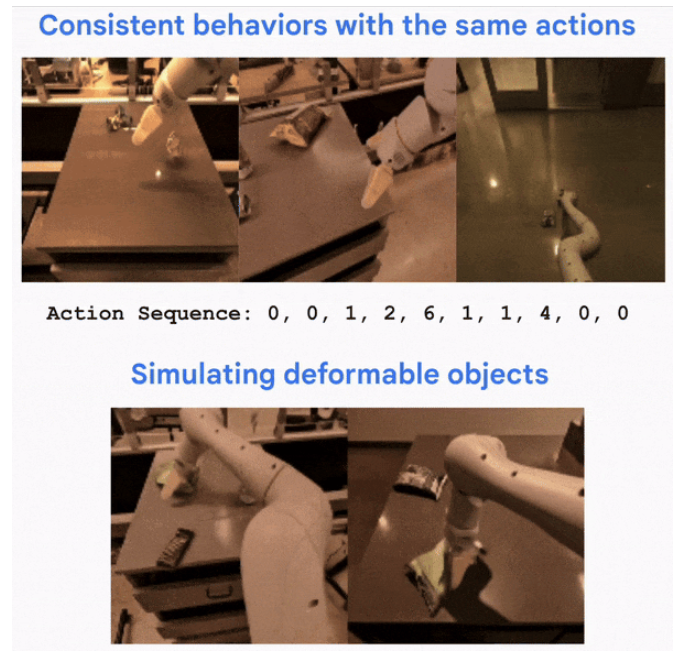

為證明這一點,團隊專門拿一些沒有動作标簽的機器人視頻訓練了一個25億參數的Genie模型。結果它不僅學會了機器人手臂的控制,還學會了各種物體的互動和薯片包這樣可變形物體的物理屬性。

由此看出,Genie能夠從機器人視頻數據創建一個動作模拟器。換句話說,就算它沒有被明确教導那些動作是什麼,也能夠看視頻學會複制和預測各種動作。

Genie團隊認為,世界模型應該是一個能夠理解和與環境交互的系統,這種交互不是預先編程的,也不限于特定任務。Genie的核心是利用未标記視頻數據進行無監督學習,并創建「生成式互動環境」,正是為實現AGI而邁出的重要一步。

當然,Genie還沒有發布日期,目前隻是作為一個研究項目,是否會成為真正的産品也還不清楚。除此以外,Tim也開誠布公地說,“Genie運行速度是每秒1幀,因此現在距離實時可玩還有很遠的距離。”難怪乎有網友形容,這看起來像個來自80年代的“馬裡奧GPT”。

不過多數人還是報以肯定,認為短期到中期它将革新生成式遊戲,長期則有可能解鎖訓練更多領域的AI智能體。項目團隊也非常振奮,DeepMind研究總監Edward Grefenstette激動感慨道:

“今天的 Genie 可能看起來隻是像素塊的跳躍和奔跑,但它實現了可控視頻生成從0到1的巨大飛躍。幾年以後,面對更逼真的可控視頻生成,我們也許會把這看作是「威爾·史密斯吃意大利面」時刻。”

畢竟,“This is the worst it will ever be.”